Gefährliche Mathematik oder gefährlicher Mensch? – Chancen und Risiken einer algorithmisierten Welt

Das Thema Künstliche Intelligenz (KI) hat Diskussionspotential. Am 23. März 2021 diskutierten Expert*innen des BFH Zentrums Digital Society darüber, wie rational datenbasierte Entscheidungen sind und wie wir nützliche von gefährlichen KI-Anwendungen unterscheiden können. Lesen Sie hier eine kurze Zusammenfassung der Veranstaltung.

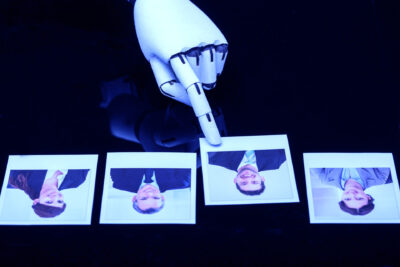

Abb.1: Der so genannte Schachtürke.

Der von Wolfgang von Kempelen entwickelte so genannte Schachtürke (1769), ein schachspielender Automat (Abbildung 1), beeindruckte bereits vor mehr als 200 Jahren mit seiner vermeintlich künstlichen Intelligenz die Kaiserin von Österreich. Hinter dem Schachtürken steht jedoch weder Zauberei noch künstliche Intelligenz, sondern ein Mensch im Innern der Maschine. Mit diesem Trick habe alles begonnen, sagt Heinrich Zimmermann, Dozent & Coach an der BFH Wirtschaft, bis 1997 der amtierende Schachweltmeister von der KI-Schachmaschine der Firma IBM geschlagen wurde. Ab diesem Zeitpunkt sei klar gewesen, dass Maschinen stärker sein können als der Mensch. Beim Schachspielen sei das nicht unbedingt ein Problem – doch wie wäre das bei einem simulierten Psychotherapie-Gespräch? Können Computer zu viel Macht zugeschrieben bekommen? Joseph Weizenbaum, deutsch-amerikanischer Informatiker, kritisiert etwa KI-Systeme, als er bemerkt, dass Assistierende ernsthafte Gespräche mit dem Simulator zu führen beginnen. Es bestünde die Gefahr, dass Computer überschätzt würden und man ihnen Fähigkeiten zuschreibe, die sie gar nicht haben, sagt Heinrich Zimmermann. Deshalb sei es wichtig zu erkennen, dass der Mensch nicht nur beim Schachtürken drin sei, sondern auch Teil der heutigen künstlichen Intelligenz ist: Der Mensch baut das System, repariert und pflegt es, bzw. die Daten und Programme. «Ohne den Menschen ist ein künstliches Intelligenzsystem gar nicht möglich.»

Wie KI diskriminiert

Mascha Kurpicz-Briki, Informatikerin an der BFH Technik & Informatik, wühlt die Teilnehmer*innen mit Negativ-Beispielen von KI-Anwendungen auf: eine Applikation für ein Passfoto-Upload zeigt bei Personen asiatischer Herkunft die Fehlermeldung an, dass die Augen geschlossen seien. Das Übersetzungstool Google Translate liefert genderstereotypisch geprägte Übersetzungen bei Sprachen mit genderneutralen Pronomen (siehe Abbildung 2). Zu den Risiken von KI gehören unter anderem Diskriminierung aufgrund Herkunft oder Geschlecht. Mascha Kurpicz-Briki erklärt: Grund für diskriminierende KI-Systeme seien die Trainingsdaten, mit welchen das System lernt Entscheidungen zu treffen. Diese enthielten bereits Stereotypen aus unserer Gesellschaft und verstärkten die bereits vorhandenen Vorurteile. Eine weitere Gefahr sei auch die Anwendung von KI für Dinge, die mit der Moral der Gesellschaft nicht vereinbar sei (z.B. Fully Automated Weapons).

Abb.2: Google Translate liefert genderstereotype Pronomen.

In Mascha Kurpicz-Brikis Beitrag sehen wir nicht nur Probleme der KI-Anwendungen, sondern lernen auch, dass KI neue Chancen eröffnen und den Menschen in der Erledigung seiner Aufgaben unterstützen kann. Der Witty Works Diversifier (Co-funded von Innosuisse) reduziert Diskriminierung bei Stellenausschreibungen, eine weitere Anwendung erkennt Hate Speech im Internet und meldet dies an die Community. Dank KI werden sogar unsere Meere wieder sauberer.

Mascha Kurpicz-Briki betont, dass die Technologie nicht grundsätzlich gut oder schlecht sei, sondern der Use Case die Rolle spiele. Statt Artifical Intelligence spricht sie lieber von Augmented Reality – denn die moralische und ethische Entscheidung und Verantwortung bleibe jederzeit beim Menschen.

Ganzheitlicher Denkansatz für die Regulierung

Im dritten Referat der Abendveranstaltung diskutiert Reinhard Riedl, wie man die Algorithmen regulieren kann, damit die Nutzung von Algorithmen mit den gesellschaftlichen Zielen übereinstimmt. Schon vor 6000 Jahren sei Computational Thinking entstanden, sagt der Leiter des BFH-Zentrums Digital Society, und bald sei der Wunsch entstanden, Rechenmaschinen zu bauen, um menschliche Fehler zu eliminieren. Der Bedarf an Regulierung entstehe durch die Wechselwirkung mathematischer Innovationen und dem exponentiellen Wachstum der Rechengeschwindigkeit. Mit der fortschreitenden Anwendung von Computational Thinking wächst und schrumpft die Transparenz zugleich, so Riedl, – es entstünde ein dynamisches Ungleichgewicht zwischen Chancen und Gefahren. Den neuen Optionen und neue Einsichten stünden Missbrauch und die Unverständlichkeit der neuen Werkzeuge gegenüber.

Datenschutz funktioniere weder, noch reiche er aus, resümiert Riedl. Akteure hätten Profile von uns, ohne dass wir uns dessen bewusst seien. Riedl plädiert in seinem Beitrag für einen neuen ganzheitlichen Denkansatz und präsentiert ein Framework mit sieben Handlungsfeldern. «Wir sollten nicht nur die Algorithmen an sich regulieren, sondern diese eingegliedert im Paket mit den Kriterien, Computational Thinking und Design der Schnittstelle zum Menschen als Gegenstand für die Regulierung betrachten. Generische Regulierungen sind nicht möglich, es braucht eine kontextabhängige Regulierung, die nicht nur die Wirkung betrachtet, sondern auch welche Narrative verwendet werden.»

Die Diskussion mit den Referent*innen im Anschluss an die drei Beiträge dreht sich um die Entwicklung fairer Chatbots, mögliche Lösungsansätze bei diskriminierenden Übersetzungen und die Frage der Regulierung von Algorithmen. Ungewiss bleibt, was man und wer tatsächlich regulieren soll. Jonas Pfister, Dissertand von Prof. DDr. Erich Schweighofer an der Universität Wien, beleuchtet das Thema aus einer rechtlichen Perspektive und betont, dass auch die Teilautomatisierung, also die Nutzung der KI im Sinne von Augmented Intelligence, rechtlich geregelt werden müsse (die Automatisierung ist über DSGVO Art. 22 geregelt). Denn die Frage sei: Ist es noch rechtskonform, wenn Menschen nur kurz Zeit haben, um eine AI-unterstützte Entscheidung zu treffen?

Mit mehr offenen Fragen als Antworten beenden wir den virtuellen Austausch und freuen uns auf weitere Diskussionen.

Videomitschnitt

Hier können Sie die Video-Aufzeichnung des Events ansehen.

Über die Veranstaltung

Die Veranstaltung des als BFH Zentrums Digital Society war ursprünglich im Frühling 2020 geplant. Am 23. März 2021 konnte sie nun virtuell über MS Teams stattfinden. Wir danken unseren Kooperationspartnern:

![]()

Create PDF

Create PDF

Beiträge als RSS

Beiträge als RSS

Dein Kommentar

An Diskussion beteiligen?Hinterlasse uns Deinen Kommentar!