Open by default oder Open by demand ? – Teil I

Über neue Goldmacher und eine komplexe Wertschöpfungskette

Die Forderung nach Open by default

Gesetzgeber auf nationaler und regionaler Ebene in Europa standen und stehen vor der Frage, ob alle Behörden gesetzlich dazu verpflichtet werden sollen, alle nicht personenbezogenen Daten kostenfrei zur Weiterverwendung unter offenen Lizenzen auf Portalen im Internet bereitzustellen, wie dies Aktivisten aus der Open Data Szene fordern („Open by default“). Die Begründung klingt einfach: Erhebung und Verarbeitung dieser Daten wurden aus Steuermitteln finanziert. Sie gehören den Bürgerinnen und Bürgern. Ihre Verbreitung durch einen Download von einem Datenportal kostet praktisch nichts. Daher können diese Daten kostenfrei bereitgestellt werden. Eine offene Lizenz schafft sogar einen volkswirtschaftlichen Nutzen, der sich auch in höheren Steuereinnahmen niederschlägt. Diese überschreiten die Kosten für die Errichtung und den Betrieb eines Datenportals bei weitem.

Seit einiger Zeit wird versucht, für diese Argumentation einen quantitativen Nachweis zu führen. In den beiden ersten Teilen dieses Beitrags werden zwei Beispiele näher betrachtet, bevor im dritten Teil grundsätzliche methodische Mängel der volkswirtschaftlichen Berechnungen kritisiert werden und am Beispiel der Freien Hansestadt Bremen eine vernünftige Lösung mit Augenmaß vorgestellt wird.

Neue Goldmacher ?

Es war wohl EU-Kommissarin Kroes, die als erste auf der Basis von sektoralen Studien in einer Pressemitteilung behauptet hat, die Verwaltungen verfügten mit ihren Daten über eine Goldmine und sollten diese Schätze zum eigenen Nutzen und zum Nutzen der gesamten Volkswirtschaft heben, indem sie ihre Daten gebührenfrei zur unbeschränkten Weiterverwendung bereitstellen (EU-Kommission 2011). In Deutschland hat die Technologiestiftung Berlin dieses Bild aufgegriffen und unter dem Titel «Digitales Gold» eine Schätzung des Nutzens durch Open Data für den Stadtstaat Berlin vorgelegt, die je nach Szenario bei 22 bis 54 Mio. € pro Jahr liegt (Preische 2014).

Ich habe diese Behauptung mit der der Goldmacher im Mittelalter verglichen, die versprochen haben, aus einfachen Rohstoffen Gold herstellen zu können, wenn ein Fürst ihnen ein Labor einrichtet. Nun sollen Politiker überredet werden, Geld in ein Projekt zu investieren, in dem aus ohnehin vorhandenen Daten auf eine nicht näher erklärte Art und Weise neue Werte in Millionenhöhe geschaffen werden. Es wäre toll, wenn defizitäre Städte wie Berlin so ihre Haushaltsprobleme verringern könnten.

Nicht jede Formel ist wissenschaftlich

Der Vorwurf mangelnder Wissenschaftlichkeit bezieht sich auf die zur Berechnung verwendete Formel. Sie wird mit volkswirtschaftlichen Termini eingeführt, beinhaltet aber bei näherer Betrachtung einige Absurditäten, die hier nur kurz angesprochen werden können (ausführlicher Kubicek 2016):

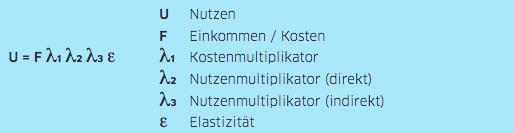

Quelle: Preische 2014, S. 34

Der Nutzen „u“ wird aus dem Einkommen bzw. den Kosten, mehreren Multiplikatoren sowie der Preiselastizität der Nachfrage bestimmt. Was stimmt daran nicht?

- Die Hauptkomponente, die mit den verschiedenen Multiplikatoren multipliziert wird, sind die Kosten F. Dass man den Nutzen über die Kosten bestimmt verwundert, wird aber damit begründet, dass Verwaltungen die Daten zu Grenzkosten bereitstellen und die Kosten somit hypothetische Preise seien, die summiert dann das Marktvolumen ausmachen.

- Noch abwegiger ist die Wahl des konkreten Kostenansatzes. Für Berlin werden die Kosten der Bereitstellung nur mit den laufenden Betriebskosten für das Open Data Portal in Höhe von 120.000 Euro angesetzt. Das sind nur die Lizenz- und Auftragskosten für den Portalbetreiber. Würde man auch die Personalkosten und die Entwicklungskosten ansetzen, würde der errechnete Nutzen steigen, ohne dass sich an dem Portal und seinem Inhalt etwas geändert hat. Oder pointiert ausgedrückt: Man muss nur viele Kosten machen, um einen großen volkswirtschaftlichen Nutzen zu erzeugen – Man kann das auch Verschwendung von Steuermitteln nennen.

- Die Multiplikatoren werden willkürlich aus überwiegend nationalen Studien übernommen.

- Für die Preiselastizität der Nachfrage nach offenen Daten wird der Wert 10 festgelegt. Das heißt bei einer Preissenkung von 1 % steigt die Nachfrage um 10%. Was aber, wenn die offenen Daten, wie es sein sollte, unentgeltlich abgegeben werden? Wäre dann die Nachfrageelastizität Null und durch den Faktor Null in den Multiplikationen der Formel auch der Nutzen gleich Null?

Die Autoren räumen selbst Mängel ihrer Untersuchung ein. Sehen diese aber nicht in ihrem Modell, sondern nur in der Datenlage (Preische 2014, S.43).

Ein Modell der komplexen Wertschöpfungskette

Nach meiner Auffassung liegt der Hauptmangel jedoch in dem verwendeten Modell einer einstufigen Wertschöpfungskette: Die Behörden stellen Daten bereit und daraus entsteht auf nicht näher beschriebene Weise ein volkswirtschaftlicher Nutzen. Es wird auch nicht erklärt, wie daraus für die Verwaltungen Einnahmen resultieren, die deren Kosten übersteigen.

Die Wertschöpfungskette für offene Daten ist sehr viel komplexer. In Abb. 1 wird versucht, dies annähernd darzustellen. Dieses Modell baut auf dem Input-Prozess-Output-Outcome-Impact-Modell auf, das zur Evaluation von Umweltprojekten entwickelt und auch zur Evaluation von Beteiligungsprozessen verwendet wurde (Aichholzer, Kubicek, Torres 2016). Es beginnt mit dem Input, insbesondere den vorhandenen Daten, und zählt dann die vielen Teilprozesse der Bereitstellung auf, die letztlich den Gesamtaufwand ausmachen.

Die Technologiestiftung unterschlägt wie viele andere Schätzungen zum Beispiel die Kosten der datenschutzrechtlichen Prüfung und einer gegebenenfalls erforderlichen Anonymisierung von Datensätzen sowie die Kosten für die Schulung der Verwaltungsmitarbeiter, die über die Zulässigkeit einer Veröffentlichung entscheiden müssen. Dies ist bei Geo- und Wetterdaten kein Problem, bei vielen anderen Daten der Verwaltungen jedoch sehr wohl.

Vor allem soll das Modell verdeutlichen, dass eine Wertschöpfung mit Rückflüssen nur entsteht, wenn die Daten für Apps verwendet werden, mit denen Umsätze erzielt und diese auch versteuert werden. Dies ist bei Geo- und Wetterdaten in Form von Werbeeinnahmen durchaus der Fall, für viele andere Daten jedoch nicht.

Für das Schweizer Bundesarchiv wurde eine Studie erstellt, die die resultierenden Steuereinnahmen schätzt. Sie soll im zweiten Teil kritisch betrachtet werden.

Quellenangaben:

Aichholzer, G., Kubicek, H., Torres, L. (2016): Evaluating e-Participation. Frameworks, Practice, Evidence. Berlin, New York u.a.

EU-Kommission (2011) Pressemitteilung „Digitale Agenda: Nutzung öffentlicher Daten als Goldmine“ Brüssel, 12. Dezember 2011 (http://europa.eu/rapid/press-release_IP-11-1524_de.htm)

Kubicek, H. (2016): Warnung vor den Goldmachern. Eine Rezension der Studie der Technologiestiftung Berlin „Digitales Gold“. Blog government 2020, 13. Juni 2016. (http://www.government2020.de/blog/?p=1731)

Preische, J. (12014): Digitales Gold. Nutzen und Wertschöpfung durch Open Data für Berlin. Technologiestiftung Berlin (https://www.technologiestiftung-berlin.de/fileadmin/daten/media/publikationen/140201_Studie_Digitales_Gold_Open_Data.pdf)

Teil II: Eine Schätzung für die Schweiz ist nur scheinbar besser

Teil III: Grundsätzliche Irrtümer und eine Lösung mit Augenmass

Create PDF

Create PDF

Beiträge als RSS

Beiträge als RSS

Dein Kommentar

An Diskussion beteiligen?Hinterlasse uns Deinen Kommentar!